در جهان پیشین، تصمیم همواره به یک فاعل انسانی گره خورده بود. حتی در پیچیدهترین ساختارهای بوروکراتیک، امکان ردیابی مسئول وجود داشت. خطا اگر رخ میداد، انسانی بود و درست به همین دلیل، میشد دربارهاش پرسش کرد، اعتراض کرد، توضیح خواست و اصلاح را مطالبه نمود. اما حالا ما در جهانی زندگی میکنیم که تصمیمها گرفته میشوند، پیامدها رخ میدهند، اما فاعل اخلاقیِ قابل پرسش، بهتدریج در جامعه ناپدید میشود. این وضعیت نه صرفاً یک تحول فناورانه، بلکه نشانه تغییری عمیق در بنیان اخلاقی نظم اجتماعی است. این نوشتار، یادآور این نکته است که الگوریتمها ابزارند، اما ابزارهایی که اگر از مسئولیت انسانی جدا شوند، به ماشینهای تصمیمسازی بیاخلاق تبدیل میشوند.

جهان معاصر بیش از هر زمان دیگری آکنده از تصمیم است؛ تصمیمهایی سریع، خودکار و مبتنی بر داده. اما در دل این انباشت تصمیم، پدیدهای بهظاهر نامرئی در حال گسترش است که میتوان از آن بهعنوان «محو شدن مسئولیت» در دنیای اکنون و پیشرو تعبیر کرد. حالا ما در جهانی زندگی میکنیم که تصمیمها گرفته میشوند، پیامدها رخ میدهند، اما فاعل اخلاقیِ قابل پرسش، بهتدریج در جامعه ناپدید میشود. این وضعیت نه صرفاً یک تحول فناورانه، بلکه نشانه تغییری عمیق در بنیان اخلاقی نظم اجتماعی است.

در جهان پیشین، تصمیم همواره به یک فاعل انسانی گره خورده بود. حتی در پیچیدهترین ساختارهای بوروکراتیک، امکان ردیابی مسئول وجود داشت. خطا اگر رخ میداد، انسانی بود و درست به همین دلیل، میشد دربارهاش پرسش کرد، اعتراض کرد، توضیح خواست و اصلاح را مطالبه نمود. اخلاق، هرچند ناکامل، اما زنده بود. مسئولیت نه حذف میشد و نه پنهان؛ بلکه به رسمیت شناخته میشد.

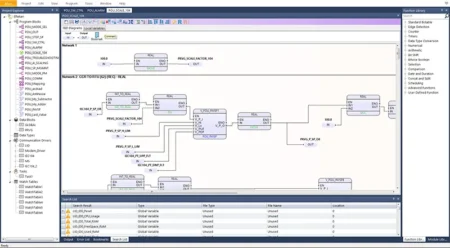

اما در نظم الگوریتمی، این پیوند بنیادین به گسست رسیده است. تصمیم وجود دارد، اما تصمیمگیر به یک «سامانه» تقلیل یافته است. الگوریتمها تصمیم میگیرند، اولویتبندی میکنند، حذف میکنند و امتیاز میدهند، بیآنکه امکان پاسخگویی اخلاقی داشته باشند. نه میتوان از آنها پرسید «چرا؟»، نه میتوان مطالبه کرد «بر چه مبنایی؟». در چنین موقعیتی، با نوعی قدرت بیچهره روبهرو هستیم؛ قدرتی که عمل میکند، اما مسئولیت نمیپذیرد!

مساله صرفاً این نیست که الگوریتمها خطا میکنند؛ مسئله این است که خطاهای آنها بیصاحب میماند. تصمیم الگوریتمی حاصل زنجیرهای از دادهها، مدلها، طراحان، مدیران و سازمانهاست. اما هنگامی که پیامد انسانیِ نامطلوبی رخ میدهد، هیچکدام خود را فاعل نهایی نمیدانند. طراح به داده ارجاع میدهد، مدیر به مدل و سازمان به «استانداردهای سامانه» و نهایتاً مسئولیت در این میان انکار نمیشود اما ناپدید میشود و دقیقاً چنین موقعیتی به همین دلیل خطرناک است.

در حوزهی اقتصاد، این فروپاشی مسئولیت به شکلی عریان قابل مشاهده است؛ تصمیمهایی که پیشتر محل گفتوگو و داوری اخلاقی بودند مانند تخصیص وام یا قطع اعتبار، اکنون به خروجیهای آماری تقلیل یافتهاند. زبان تغییر کرده است: دیگر سخن از «بیعدالتی» نیست، بلکه از «ریسک بالا» یا «امتیاز ناکافی» صحبت میشود. اخلاق به زبان فنی ترجمه میشود و همین ترجمه، آن را از امکان اعتراض تهی میکند؛ زیرا نمیتوان با یک عدد مذاکره اخلاقی انجام داد!

در بازار کار نیز وضعیت مشابهی در حال تثبیت است. ارزیابی عملکرد، ارتقا یا حتی حذف نیروها، بیش از آنکه بر قضاوت انسانی استوار باشد، به شاخصها و امتیازها وابسته شده است. مدیران بهتدریج از جایگاه داور اخلاقی کنار میروند و خود را صرفاً مجری توصیههای سامانه میدانند. قدرت باقی میماند، اما مسئولیت اخلاقی از آن جدا میشود. تصمیم گرفته میشود، اما هیچکس خود را پاسخگوی پیامد انسانی آن نمیبیند و این وضعیت بسیار خطرناک است.

در لایهای عمیقتر، آنچه دگرگون شده، معنای خودِ «خطا»ست. در نظم انسانی، خطا امری اخلاقی بود؛ رخدادی که میشد دربارهاش سخن گفت، پوزش خواست و از آن آموخت. در نظم الگوریتمی، خطا به «نیاز به بهینهسازی مدل» یا «اصلاح پارامترها» فروکاسته میشود.

آنچه دگرگون شده، معنای خودِ «خطا»ست. در نظم انسانی، خطا امری اخلاقی بود؛ رخدادی که میشد دربارهاش سخن گفت، پوزش خواست و از آن آموخت. در نظم الگوریتمی، خطا به «نیاز به بهینهسازی مدل» یا «اصلاح پارامترها» فروکاسته میشود.

سامانه اصلاح میشود، اما رنج انسانیِ ناشی از تصمیم پیشین بیصدا باقی میماند. الگوریتم یاد میگیرد، اما جامعه فراموش میکند.

خطر اصلی این وضعیت، عادیشدن بیمسئولیتی است. جامعهای که به «تصمیمهای بیچهره» خو بگیرد، بهتدریج توان مطالبه اخلاقی خود را از دست میدهد و اعتراض دشوار میشود؛

جامعهای که به «تصمیمهای بیچهره» خو بگیرد، بهتدریج توان مطالبه اخلاقی خود را از دست میدهد و اعتراض دشوار میشود

زیرا مخاطب مشخصی ندارد. گفتوگو ناممکن میشود؛ زیرا طرف مقابل «سامانه» است. در چنین نظمی، عدالت پیش از آنکه نقض شود، تهی میشود؛ زیرا دیگر کسی نیست که در برابر آن پاسخگو باشد.

بیشک مسئله این نوشتار، نفی فناوری یا بازگشت نوستالژیک به گذشته نیست؛ بلکه یادآوری این نکته است که الگوریتمها ابزارند، اما ابزارهایی که اگر از مسئولیت انسانی جدا شوند، به ماشینهای تصمیمسازی بیاخلاق تبدیل میشوند. هر تصمیم الگوریتمی باید به یک فاعل انسانی قابل شناسایی متصل باشد؛ کسی که نهتنها کارایی سامانه، بلکه پیامدهای انسانی آن را نیز بپذیرد. بدون این اتصال، فناوری نه بیطرف، بلکه بیمسئولیت خواهد بود و عدالت بدون مسئولیت، به عدد تقلیل مییابد و قدرت بدون پاسخگویی، به سلطهی خاموش تبدیل میشود و جامعهای که تصمیم میگیرد اما پاسخ نمیدهد، پیش از آنکه ناعادلانه شود، غیرانسانی میشود.

در پیشروی چنین تصور مهیبی از وضعیتِ جهانِ پیشرفته تا مرزهای فناوریهای جدید و حکمرانی بلاقید الگوریتمها، پرسش مخوف اما مأیوسکنندهای پابرجا است: وقتی تصمیمها را ماشینها میگیرند، چه کسی هنوز مسئول انسان و انسانیت است؟

وقتی تصمیمها را ماشینها میگیرند، چه کسی هنوز مسئول انسان و انسانیت است؟