تحلیلهای بینالمللی هشدار میدهند که استفاده از هوش مصنوعی در عملیات سایبری افزایش یافته است. به دیگر سخن استفاده از هوش مصنوعی در فیشینگ، تولید محتوای جعلی و خودکارسازی حملات رو به افزایش است. سامانههای تشخیص نفوذ امروزی بطور فزایندهای بر الگوریتمهای یادگیری ماشین و یادگیری عمیق تکیه میکنند تا الگوهای ترافیک مخرب را شناسایی کنند. اما این پیشرفت، حملات جدیدی را نیز به همراه داشته است: حملات علیه خودِ مدلهای یادگیری، آنچه در ادبیات، «هوش مصنوعی معکوس» یا «یادگیری ماشین ستیزهجویانه» نامیده میشود. در این نوشتار بررسی کردهایم که چگونه مهاجمان میتوانند مدلهای تشخیص نفوذ را فریب دهند، همچنین به نمونههای رایج حملات، روشهای دفاعی و توصیههای عملی برای بهبود مقاومت سامانهها پرداختهایم.

تحلیلهای بینالمللی مانند یونیت42، هشدار میدهند که دو سال اخیر استفاده از هوش مصنوعی در عملیات سایبری منطقهای و بینالمللی افزایش یافته و این میتواند تعداد قربانیان شرکتی را بالا ببرد، به دیگر سخن استفاده از هوش مصنوعی در فیشینگ، تولید محتوای جعلی و خودکارسازی حملات رو به افزایش است. بنابراین انتظار میرود تعداد شرکتهایی که تحت تأثیر قرار میگیرند هم افزایش یابد.

سامانههای تشخیص نفوذ[i] (IDS/IPS) امروزی بطور فزایندهای بر الگوریتمهای یادگیری ماشین و یادگیری عمیق تکیه میکنند تا الگوهای ترافیک مخرب را شناسایی کنند. اما این پیشرفت، حملات جدیدی را نیز به همراه داشته است: حملات علیه خودِ مدلهای یادگیری، آنچه در ادبیات، «هوش مصنوعی معکوس» یا «یادگیری ماشین ستیزهجویانه» نامیده میشود. در این نوشتار بررسی کردهایم که چگونه مهاجمان میتوانند مدلهای تشخیص نفوذ را فریب دهند، همچنین به نمونههای رایج حملات، روشهای دفاعی و توصیههای عملی برای بهبود مقاومت سامانهها پرداختهایم.

چیستی و انگیزهی مهاجم

هوش مصنوعی معکوس به حملاتی گفته میشود که هدفشان تغییر ورودیها یا دادههای آموزش بگونهای است که مدل یادگیری اشتباه کند بیآنکه رفتار ظاهری خیلی متفاوت به نظر برسد.

هوش مصنوعی معکوس به حملاتی گفته میشود که هدفشان تغییر ورودیها یا دادههای آموزش بگونهای است که مدل یادگیری اشتباه کند بیآنکه رفتار ظاهری خیلی متفاوت به نظر برسد.

انگیزهی مهاجم در زمینهی تشخیص نفوذ بطور معمول شامل فرار از شناسایی، کاهش دقت سامانه، یا تحریف فرایندهای پاسخدهی خودکار است. مهاجم ممکن است کد مخرب را به گونهای بسازد که به نظر قانونی بیاید یا در محیطهای توزیعشده دادههایی وارد کند که مدل را در طول زمان «سمی» کند.

سطوح اصلی حملات علیه IDS

IPS سامانهی شناسایی و جلوگیری از حمله و نفوذ به شبکه است و IDS یک سامانهی حفاظتی است که خرابکاریهای در حال وقوع روی شبکه را شناسایی میکند.

IPS سامانهی شناسایی و جلوگیری از حمله و نفوذ به شبکه است و IDS یک سامانهی حفاظتی است که خرابکاریهای در حال وقوع روی شبکه را شناسایی میکند.

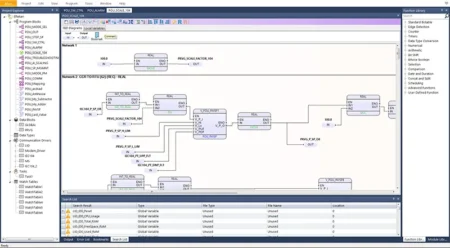

اینها مشخصات مشترک زیادی دارند. در حقیقت، بیشتر سامانههای تشخیص نفوذ در هستهی خود یک سامانهی جلوگیری از نفوذ دارند. تفاوت کلیدی بین این فناوریها این است که محصولات IDS تنها ترافیک آسیبرسان را تشخیص میدهند، در حالی که محصولاتIPS از ورود چنین ترافیکی به شبکه جلوگیری میکنند، با این مقدمه حمله به IDS در چهار سطح انجام میشود:

- حملات اجتناب: مهاجم پس از آگاهشدن از مدل (یا با حدس زدن)، نمونههای مخرب را طوری دستکاری میکند که از فیلترها و قوانین عبور کنند. مثال: تغییر توالی بستهها، افزودن یا حذف فیلدهای غیرضروری در پروتکل تا رفتار ترافیک شبیه ترافیک قانونمند شود و مدل تشخیص ندهد.

- حملات آلودهسازی آموزش: مهاجم دادههای آموزشی یا برچسبها را دستکاری میکند تا مدل در مرحلهی آموزش یاد بگیرد که نمونههای مخرب را نادیده بگیرد. در محیطهایی که یادگیری آنلاین یا بهروزرسانی مکرر انجام میشود، این حملات بسیار اثرگذارند.

- حملات استنتاج: مهاجم با پرسوجوهای متعدد سعی میکند ساختار یا پارامترهای مدل را بیرون کشد تا حملات هدفمندتری طراحی کند. برای IDS مبتنی بر رابط برنامهنویسی کاربردی یا خدمت ابری این تهدید واقعی است.

- حملات مبتنی بر انتقال: اغلب نمونههای جعلی که برای یک مدل ساخته شدهاند میتوانند مدلهای دیگر را نیز فریب دهند. بنابراین مهاجم حتی بدون دسترسی مستقیم به مدل هدف میتواند با ساختن حمله علیه مدل جانشین موفق شود.

روشهای متداول برای ایجاد نمونههای مخرب

- گرادیانمحور: در مدلهای یادگیری عمیق معمول است که از گرادیان تابع هزینه برای پیدا کردن کوچکترین تغییر ممکن در ورودی استفاده شود تا مدل را فریب دهد.

- بهینهسازی مبتنی بر تخصیص ویژگی: تغییر مقادیر ویژگیها (مثلاً زمان بین بستهها، اندازهی بستهها، فلگها) با محدودیتهای عملیاتی تا ترافیک همچنان قابلپخش باشد.

- حذف یا افزودن نویز حسابشده: افزودن نویز شبکهای یا اضافهکردن بستههای پوششی که از نظر عملکرد سرویس مشکلساز نباشند اما مدل را فریب دهند.

پیامدها برای تشخیص نفوذ

حملات موفق میتوانند باعث شوند که:

- تهدیدات جدی بدون هشدار عبور کنند؛

- نرخ منفی کاذب افزایش یابد، یعنی یکسری آسیب پذیری که واقعاً وجود دارد، شناسایی نمیشود و اطمینان کارشناسان کاهش یابد؛

- هزینههای پاسخ و ترمیم افزایش یابد و اعتماد به سامانه کاهش پیدا کند؛

- در سناریوهای حساس (دیتاسنترها، زیرساختهای حیاتی) مخاطرات بالایی ایجاد شود.

روشهای دفاعی و مقاومسازی

هیچ راهحل واحدی کامل نیست، اما ترکیب چند لایهی دفاعی میتواند ریسک را کاهش بدهد:

- آموزش مقاوم: در طول آموزش، نمونههای اعتراضی تولیدشده به دادهها اضافه میشوند تا مدل یاد بگیرد در برابر آنها مقاوم باشد. این روش مؤثر است ولی هزینهی محاسباتی و نیاز به مجموعه نمونههای معنادار دارد.

- استخراج ویژگی مقاومبه دستکاری: انتخاب یا مهندسی ویژگیهایی که تغییر آنها برای مهاجم سخت یا پرهزینه باشد (مثلاً ویژگیهای مبتنی بر رفتار بلندمدت یا پروفایلهای کاربری) کمک میکند تا فریبپذیری کاهش یابد.

- پیشپردازش و تصفیه ورودی: نرمالسازی، حذف نویز، فشردهسازی یا بازسازی ترافیک پیش از وارد کردن به مدل میتواند برخی از حملات مبتنی بر نویز را خنثی کند.

- تجزیه و تحلیل پاسخ چندمدلی: استفاده از چند مدل متفاوت (مثلاً کلاسیک و عمیق) بههمراه مکانیزمهایی برای تشخیص تغییر توزیع داده[ii] که نشاندهندهی آلودگی یا حملهی درازمدت است.

- مدیریت دادههای آموزشی: کنترل منبع دادهها، اعتبارسنجی برچسبها، و محدود کردن مسیرهای آپلود دادههای آموزشی میتواند از حملات مسمومیت دادهها جلوگیری کند.

- پایش و هشدارهای رفتاری: الگوریتمهای تشخیص رفتار غیرمعمول مدل یا الگوهای پرسوجو جهت شناسایی تلاشهای استخراج مدل.

- تجهیزات شبکهای و قوانین افزایشی: بکارگیری مکانیزمهای شبکهای سنتی (فایروال، نرخدهی،IPS مبتنی بر قانون) در کنار مدلهای یادگیری برای پوشش نقاط کور.

سنجش و ارزیابی مقاومت

برای ارزیابی، باید از سناریوهای حمله واقعگرایانه استفاده کنیم:

- معیارهایی فراتر از دقت کلی: نرخ منفی کاذب تحت حمله، نرخ تشخیص حمله جدید، هزینهی حمله برای مهاجم؛

- آزمونهای انتقالپذیری: آیا حملهای که روی مدل A ساخته شده مدلهای B و C را هم فریب میدهد؟

- آزمونهای پویا: ارزیابی سامانه در محیط زنده با دادههای جریاندار و بهروزرسانی مدل.

چالشها و محدودیتها

- هزینهی محاسباتی: تولید و آموزش با نمونههای اعتراضی سنگین است؛

- واقعگرایی نمونهها: نمونههای ساختهشده با هدف فریب مدل باید در دنیای واقعی قابلارسال و کارا باشند؛

- تعامل انسان و ماشین: افزایش مقاومت مدل معمولاً با کاهش تفسیرپذیری یا افزایش پیچیدگی همراه است؛

- دورهی بهروزرسانی مهاجم/مدافع: مسابقهای مستمر میان مهاجمان و مدافعان وجود دارد که به سرمایهگذاری مستمر نیاز دارد.

توصیههای عملی برای تیمهای امنیتی

- مدلهای تولیدی را تحت آزمونهای اعتراضی منظم قرار دهید؛

- از چند لایهی دفاعی استفاده کنید، یادگیری ماشین تنها قطعهای از پازل است؛

- منابع و مسیرهای آموزش آنلاین را محافظت کنید تا حملات مسمومیت دادهها سختتر شوند؛

- معیارهای پایش را گسترش دهید تا تغییرات توزیع داده در زمان واقعی شناسایی شود؛

- در سیاستهای پاسخ، سناریوهای فرار از تشخیص را لحاظ کنید و تستهای «قرمز تیم» برای تلاش واقعی اجرا کنید؛

- مستندسازی و گزارشپذیری: هر مورد خطا یا تزریق داده باید قابل ردیابی باشد تا ریشه آسیب مشخص شود.

نتیجهگیری

هوش مصنوعی معکوس یک تهدید واقعی برای سامانههای تشخیص نفوذ مبتنی بر یادگیری ماشین است؛ اما با اجرای ترکیبی از تکنیکهای مقاومسازی (آموزش مقاوم، انتخاب ویژگیهای پایدار، پیشپردازش، و دفاع لایهای) میتوان ریسک را بطور قابلتوجهی کاهش داد. مهم است که سازمانها یاد بگیرند تنها به بهبود دقت در شرایط ایدهآل بسنده نکنند و آزمایشهای واقعگرایانه حملات و پایش پیوسته را به عنوان بخش جداییناپذیر فرآیند توسعه و بهرهبرداری مدلها بپذیرند.

[i] Intrusion Detection System/Intrusion Prevention Systems

[ii] data drift detection